Das Gespräch führten ANDREAS BULLIK und KAY MEINERS.: Frau Zweig, was können Computer besser, und was Menschen?

Interview Informatik-Expertin Katharina Zweig erklärt, was Algorithmen sind, wie Computer Bewerbungen analysieren – und warum wir eine gesellschaftliche Debatte über Algorithmen brauchen

Das Gespräch führten ANDREAS BULLIK und KAY MEINERS.

Frau Zweig, Sie erforschen Software, die Entscheidungen automatisiert treffen kann. Ist das nicht ein bisschen unheimlich?

Nein, ich bin sicher, dass die Vorteile größer sein werden als die Nachteile, wenn wir die Technik verantwortlich einsetzen. Heikel wird es dort, wo Menschen bewertet werden oder wo über gesellschaftliche Teilhabe entschieden wird – etwa in der Justiz oder im Personalmanagement.

Was ist ein Algorithmus? Das Wort soll vom Namen eines Mathematikers abgeleitet sein, der im 9. Jahrhundert in Bagdad lehrte: Muhammad ibn Musa Al-Chwarizmi.

Ja. Latinisiert schreibt sich der Name Algorismi. Al-Chwarizmi hat aus Indien die Null in das arabische Zahlensystem eingeführt und ein Rechenbuch geschrieben, dessen systematische Herangehensweise an Probleme damals ungewöhnlich war. Algorithmen sind daher einfach genau definierte Rechenverfahren.

Was genau bedeutet das?

Erinnern Sie sich, wie Sie in der Schule gelernt haben, schriftlich zu multiplizieren? Ihre Lehrerin hat Ihnen nicht jeden Fall einzeln beigebracht, sondern eine Reihe von Handlungsanweisungen für ein allgemeines Problem. Das ist ein Algorithmus. Ebenso enthält das Navigationssystem eine Folge von Anweisungen, mit der es die – in Kilometern gemessen –kürzeste Straßenverbindung zwischen zwei Orten identifiziert.

Warum setzen wir für so viele Aufgaben Computer ein?

Es gibt mehrere Gründe. Wir Menschen sind beim Rechnen sehr langsam und machen Fehler. Zudem verlieren wir bei komplexen Aufgaben den Überblick – das passiert Computern nicht. Vor allem aber haben wir die Hoffnung, dass der Computer etwas weiß, das wir noch nicht wissen.

Wie gelingt das?

Algorithmen können in großen Datenmengen Muster erkennen, wo wir als Mensch nichts wahrnehmen außer Rauschen. In der Brustkrebsforschung habe ich mit Kollegen mithilfe eines Algorithmus aus mehr als 800 Biomolekülen zehn Moleküle identifiziert, von denen wir hofften, dass sie eine bestimmte, tödliche Variante dieser Krankheit stoppen könnten. Mit denen sind wir ins Labor gegangen – und drei waren wirksam.

Machen Algorithmen auch Fehler?

Ja. Die Aufgabe, den kürzesten Weg in Kilometern zu finden, kennt eine einfache Lösung. Schwieriger ist es, Sie in einer konkreten Verkehrssituation möglichst schnell von einem Ort zum anderen zu bringen. Der Algorithmus muss eine Vorhersage machen. Wir kennen aus der Vergangenheit die statistische Wahrscheinlichkeit eines Unfalls. Aber wann und wo wird der Unfall passieren? Wir wissen es nicht. Ab jetzt ist der Algorithmus mit einer Unsicherheit behaftet.

Warum sind solche Programme problematisch?

Weil mit ihrer Hilfe auch Urteile über Menschen gefällt werden. In Polen werden so zum Beispiel Arbeitslose klassifiziert. Es wird entschieden, wer eine Weiterbildung bekommt und bei wem es sich nicht mehr lohnt. Und in den USA werden Kriminelle daraufhin beurteilt, ob sie wahrscheinlich wieder rückfällig werden oder nicht. Hier werden Menschen mit Daten anderer Menschen aus der Vergangenheit beurteilt.

Sind das nicht einfach Entscheidungen, die auf Erfahrungswissen beruhen?

Die Entscheidungen sind eher algorithmisch legitimierte Vorurteile. Nehmen wir an, ich stelle einen Kreditantrag, und ich werde vom Algorithmus einer Gruppe zugerechnet, deren Mitglieder zu 90 Prozent den Kredit zurückzahlen. Eigentlich interessant ist, zu welcher Teilgruppe ich gehöre – zu den 90 Prozent, die zahlen, oder zu den zehn Prozent, die nicht zahlen? Wahrscheinlich bekomme ich den Kredit, wenn der Algorithmus mich dieser Gruppe zuordnet. Aber wenn nicht, kann ich mich beschweren? Was Algorithmen aber überhaupt nicht abbilden können, sind Ermessensspielräume.

Wie wirkt sich das aus?

Noch ein Beispiel: Eine Sachbearbeiterin, die über die Angemessenheit von Wohnraum bei Hartz-4-Beziehern entscheidet, kann eine Miete von fünf Euro über dem Regelsatz akzeptieren, weil ein Umzug unverhältnismäßig wäre. Für den Computer ist die Wohnung einfach zu teuer. Er entscheidet mit einer Härte, die sozial unerwünscht ist. Das Problem ist so selten, dass ein Algorithmus es wahrscheinlich nicht lernen kann.

Was heißt in diesem Zusammenhang „lernen“?

Algorithmen können besser werden, wenn man sie mit Daten füttert. Oder ein Mensch, ein Trainer, stellt für die jeweilige Eingabe den korrekten Output bereit, bis der Algorithmus auf ähnliche Eingaben so reagiert, wie es erwünscht ist. Am Ende aber muss die Gesellschaft entscheiden: Ist das, was möglich ist, auch sinnvoll? Ist es fair? Ist es demokratisch?

Gehen verschiedene Gesellschaften unterschiedlich mit Algorithmen um?

Extrem. In den USA sind es Bürgerrechtler, die fordern, dass im Strafprozess an allen Stellen algorithmische Systeme eingesetzt werden. Sie tun das, weil sie glauben, dass die Richter vorurteilsbeladen sind. Afroamerikaner werden dort sechsmal so oft inhaftiert, wie man nach ihrem Anteil an der Bevölkerung erwarten könnte, Latinos doppelt so häufig. Eine Studie zeigte auch, dass Richter strenger über Haftentlassungen entscheiden, wenn die letzte Mahlzeit länger zurückliegt. Das ist nicht gerecht. Hier sind konsistent entscheidende Algorithmen besser. Sie sind gut darin, Gleiches auch gleich zu behandeln.

Und wie ist es in China?

Hier hat sich etwas ganz Schwieriges entwickelt. Als dort der Onlinehandel immer mehr wuchs, gab es keine Informationen über die Kreditwürdigkeit der Teilnehmer. Es fehlte an Vertrauen. Die Plattformen begannen, Bewertungssysteme zu entwickeln. Dann sagte die Regierung auf einmal: So etwas brauchen wir. Jetzt soll aber auch gemessen werden, wie „bürgerlich“ jemand ist: Äußert er sich kritisch in sozialen Medien? Verhält er sich konform oder ungewöhnlich? Wenn Sie sich kritisch äußern und ich auf einer Social-Media-Plattform wie Weibo, dem chinesischen Twitter, mit Ihnen bekannt bin, dann verschlechtert sich auch mein Score.

Das führt zu sozialer Isolation von Regimekritikern.

Ja. Sogar der Zugang zu Bussen, Bahnen oder Flugzeugen soll bei einem schlechten Wert eingeschränkt werden. Global gesehen gibt es sehr unterschiedliche Motivationen, Algorithmen einzusetzen. Manchmal geht es einfach um Effizienz. Manchmal geht es um Bürgerrechte, wie in der US-Justiz. Und manchmal um ein Regime, das sicherstellen will, dass die Bürger sich im Sinne des Regimes korrekt verhalten.

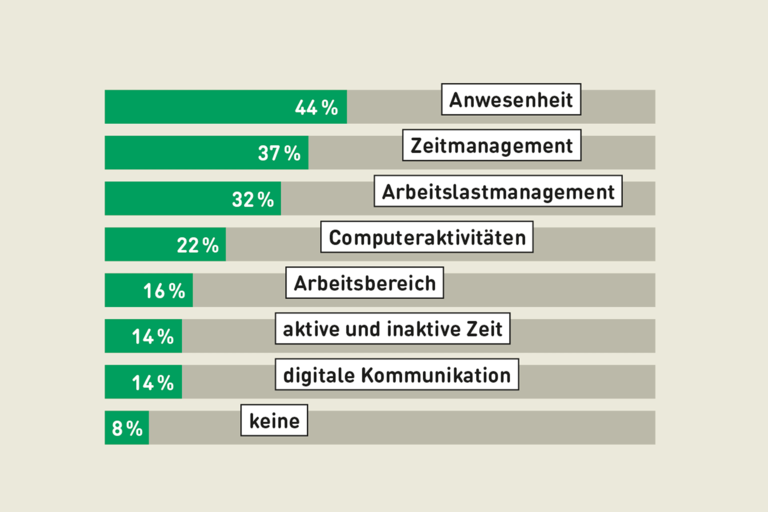

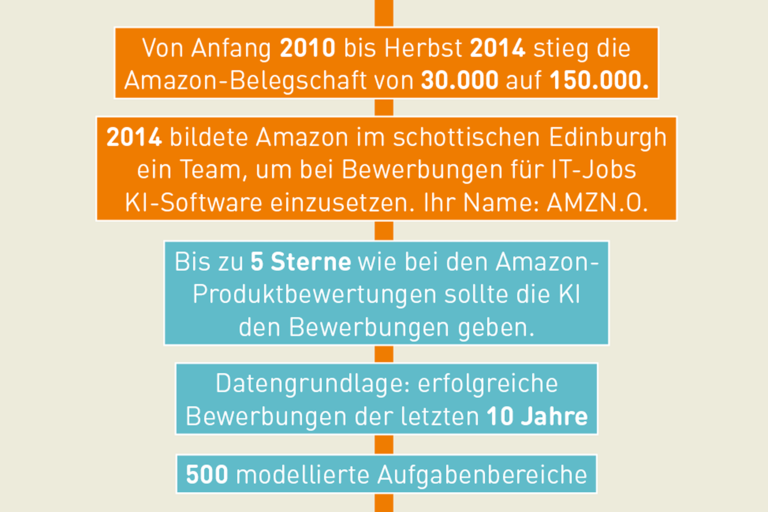

Ein Thema, das Sie sehr beschäftigt, sind Bewerbungsverfahren und Personalmanagement. Wie werden hier Menschen beurteilt?

Es ist relativ leicht, Lebensläufe automatisch zu lesen und die 20 Prozent schlechtesten auszusortieren – unvollständige Bewerbungen, Texte in ganz schlechtem Deutsch oder Motivationsschreiben, die gar nicht zur Firma passen. Das sind aber Routineaufgaben, die auch ein Mensch ziemlich schnell erledigen kann.

Wie wird weiter sortiert?

Als Nächstes liest die Maschine vielleicht: Der Bewerber hat das Wirtschaftsstudium in dreieinhalb Jahren geschafft, ein Auslandssemester absolviert und jetzt den ersten Arbeitgeberwechsel. Er kommt von einer guten Firma. Ein guter Kandidat. Wenn aber daraus eine allgemeine Regel gemacht wird, kann das dazu führen, dass man einen Einheitsbrei einstellt. Unter Umständen wäre es aber besser, die 45 Jahre alte Japanologin einzustellen, die eine tolle Persönlichkeit hat und einen ganz frischen Blick mitbringt.

Warum gibt der Algorithmus ihr eine schlechtere Chance – oder keine?

Algorithmen standardisieren – und das möglicherweise stärker, als man das möchte. Sie können nicht erkennen, wer in einer positiven Weise vom Standard abweicht. Dabei ist das menschliche Verhalten gar nicht zu 100 Prozent vorhersagbar. Sie können jemanden einstellen, der sehr motiviert ist. Alles zeigt auf Erfolg. Und im nächsten Monat wird sein Kind schwer krank. Dann kann sich alles ändern. Auch eine Bewerberin, die vielleicht zuerst nicht passfähig erscheint, kann eine sehr guter Mitarbeiterin werden.

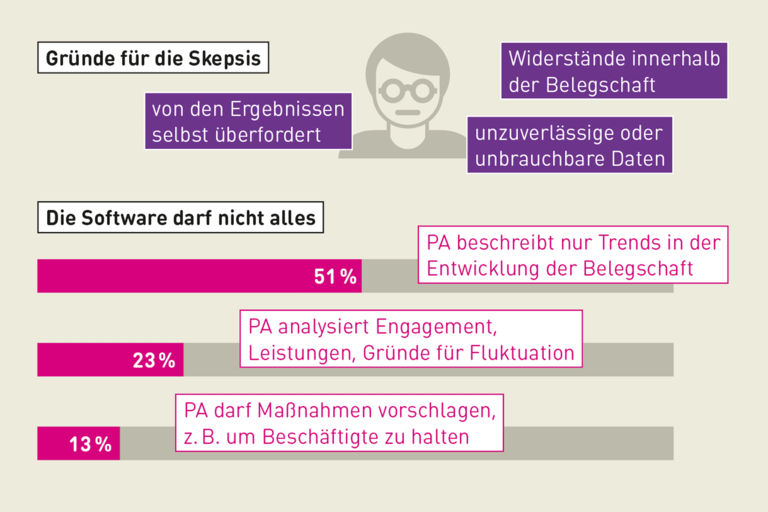

Was muss man tun, damit der Algorithmus einer Bewerbungssoftware fair arbeitet?

Es gibt hier eine systematische Schwierigkeit, auf die es keine einfache Antwort gibt. Wir beobachten, dass von der Gesellschaft verschiedene Maße von Fairness an ein Problem angelegt werden, die mathematisch nicht kompatibel sind. Man kann entweder die eine Art von Fairness erreichen oder die andere.

Das müssen Sie erklären.

Lassen Sie uns versuchen, Menschen in zwei Klassen einzuteilen: in Positive, die voraussichtlich beruflich Erfolg haben werden, und in Negative, die beruflich eher erfolglos sein werden. Um die Prognoseleistung später überprüfen zu können, müssen wir definieren, was Erfolg überhaupt ist. Zum Beispiel: Erfolg heißt, später einmal mindestens 5000 Euro brutto zu verdienen – natürlich eine völlig unzulässige Vereinfachung, die aber für den Computer gut messbar ist. Der Algorithmus wird in jedem Fall Fehler machen. Viel mehr als 60 bis 80 Prozent Trefferquote kriegt man kaum hin.

Er sortiert Menschen also falsch ein.

Genau. Es wird Menschen geben, denen er Erfolg vorhersagt, die aber später weniger als 5000 Euro verdienen. Das sind die Falsch-Positiven. Und es wird Menschen geben, denen er Misserfolg vorhersagt, die aber später mehr als 5000 Euro haben. Das sind die Falsch-Negativen. Ganz abgesehen davon, dass Erfolg natürlich nicht am Lohn ablesbar ist.

Wie geht das Experiment weiter?

Wir müssen noch eine Annahme treffen. Wir nehmen zusätzlich an, dass die Gruppe von Menschen, die wir klassifizieren, aus Männern und Frauen besteht. Ein Maß für Fairness besagt nun: In beiden Teilgruppen – Männer und Frauen – sollen prozentual gleich viele Personen sein, die später tatsächlich ein Gehalt von 5000 Euro erreichen. Ein anderes Maß für Fairness besagt: Wenn ich Prognosefehler mache, sollen diese Fehler beide Geschlechter mit gleicher Häufigkeit treffen.

Beide Kriterien scheinen gut begründbar.

Je nachdem wie die gesellschaftliche Realität aussieht, ist es aber mathematisch nicht möglich, beide Fairnessmaße zugleich zu erfüllen. Zum Beispiel, wenn Frauen strukturell schlechter bezahlt werden. Das erste Maß anzuwenden, bedeutet dann, bei den Männern mehr Prognosefehler zuzulassen. Und das zweite Maß anzuwenden bedeutet, am Ende weniger Frauen im Pool zu haben, die tatsächlich 5000 Euro oder mehr verdienen. Aus ähnlichen Gründen sind auch manche Algorithmen, die wir in der US-Justiz finden, rassistisch.

Was bedeutet das für die Praxis?

Hier muss die Gesellschaft eine Entscheidung treffen. Man kann entweder die eine Art von Fairness erreichen, oder die andere. Und man muss immer fragen: Wie verändert sich der soziale Prozess, wenn Algorithmen eingesetzt werden?

Solche Fragen erforscht die Sozioinformatik, die Sie mitbegründet haben.

Man darf Methoden nicht unabhängig von dem sozialen Raum betrachten, in dem sie eingesetzt werden. Wenn ein Personaler oder ein Richter Fehler macht, wird er erklären müssen, warum er der Empfehlung der Maschine nicht gefolgt ist. Ich sehe das alles etwas kritisch.

Zurück zur Bewerbungsrunde? Wir suchen immer noch den idealen Kandidaten. Kann der Computer ihn finden?

Ich fände es ganz falsch, einen Menschen am Ende auf eine einzige Kennzahl zu reduzieren. Besser sind Messsysteme, die einen Menschen in mehreren Dimensionen bewerten: Fachwissen, soziale Kompetenz, Erfahrung, Kreativität, Engagement.

Und dann wird wieder gerechnet, wer die meisten Punkte hat?

Mir ist lieber, wenn die Maschine explorativ Muster und Zusammenhänge austestet, und dann ein Mensch darüberschaut. Das ist eine Riesenchance. Denn viele Entscheidungen würden anders getroffen, wenn die Datenbasis besser wäre. Wo es um gesellschaftliche Teilhabe geht, müssen wir aber besonders sorgfältig prüfen und reflektieren, was wir überhaupt tun. Die Arbeitswelt gehört unbedingt dazu.

Welche Möglichkeiten sehen Sie für den Einsatz im Betrieb?

Man kann Menschen mit Sensoren bei der Arbeit ausstatten und beobachten, wer die meisten Stückzahlen am Band liefert oder die wenigsten Fehler produziert. Man kann aber auch mithilfe solcher Technik dafür sorgen, dass Pausen wirklich eingehalten werden. Oder man kann eine Fehlhaltung erkennen und sagen: Dieser Mann da geht so gekrümmt, da zeichnet sich ein Rückenleiden ab, wenn wir nicht gegensteuern. Die Bandbreite ist groß. Aber die meisten Betriebe nutzen ihre Daten heute noch zu wenig, um mit lernenden Algorithmen zu arbeiten.

Wie reagieren die Arbeitnehmer auf den Einsatz algorithmischer Technik?

Sehr unterschiedlich. Die einen sagen: Mir ist recht, wenn ich weiß, wonach ich beurteilt werde. Das ist besser als Vorgesetzte, denen meine Nase nicht passt. Andere haben Angst davor, überwacht zu werden.

Welche Erfahrungen haben Sie mit Gewerkschaftern und Betriebsräten gemacht?

Ganz ehrlich: Ich dachte, dass da die Bedenkenträger sitzen. Das ist aber nicht so. Ich bin auf eine große Offenheit gestoßen und viel Neugier. Aber auch auf Betriebsräte, die sagen: Wenn wir uns damit auch noch befassen sollen, überfordert es uns. Darum brauchen wir eine gesellschaftliche Debatte, die dazu führt, dass die Algorithmen, die eingesetzt werden, sauber sind und dass wir Systeme bauen, die im Betrieb von Nutzen sind.

ZUR PERSON

Katharina A. Zweig, Jahrgang 1976, ist Informatikprofessorin an der TU Kaiserslautern. Das besondere Interesse der Biochemikerin und Informatikerin gilt Netzwerkstrukturen. Die mathematischen Methoden, mit denen man solche Strukturen untersucht, sind oft Algorithmen. Zweig wunderte sich, dass es viele verschiedene Messmethoden mit sehr unterschiedlichen Ergebnissen gab. Sie interessiert, wann welches Maß sinnvoll eingesetzt werden kann, und was damit über die reale Welt ausgesagt wird. Sie hat daher einen eigenen Studiengang entwickelt – die Sozioinformatik.

Zweig gründete 2016 zusammen mit Lorena Jaume-Palasí, Lorenz Matzat und Matthias Spielkamp die Plattform AlgorithmWatch, die sich für mehr Transparenz und gesellschaftliche Kontrolle im Umgang mit Algorithmen einsetzt. Weiterhin ist sie im Beirat eines Forschungsprojektes der Hans-Böckler-Stiftung über den Einsatz von Algorithmen im automatisierten Personalmanagement und die Folgen für die Mitbestimmung.

WEITERE INFORMATIONEN

Weitere Artikel zum Thema „Macht der Algorithmen“

Einsatz von Algorithmen: Was sagen die Gewerkschaften? Wo sind rote Linien, wie können das Arbeitnehmervertreter gestalten? Die Gewerkschaftsvorstände Christiane Klenner und Francesco Grioli geben Antworten.

Rezension von „Angriff der Algorithmen“: Mathematik als Waffe